O Nobel da Física de 2024 foi atribuído a John Hopfield e Geoffrey Hinton pelo trabalho que desenvolveram em torno de redes neuronais e aprendizagem automática, modelos utilizados na IA. De acordo, com o comunicado do Instituto Superior Técnico (Técnico): “Estes trabalhos inspiraram muitos cientistas a explorar redes neuronais e foram contributos muito importantes para o desenvolvimento das técnicas mais modernas de inteligência artificial e aprendizagem automática que estão a revolucionar a forma como vivemos e trabalhamos”. (https://tecnico.ulisboa.pt/pt/noticias/nobel-da-fisica-2024-um-comentario-do-tecnico/)

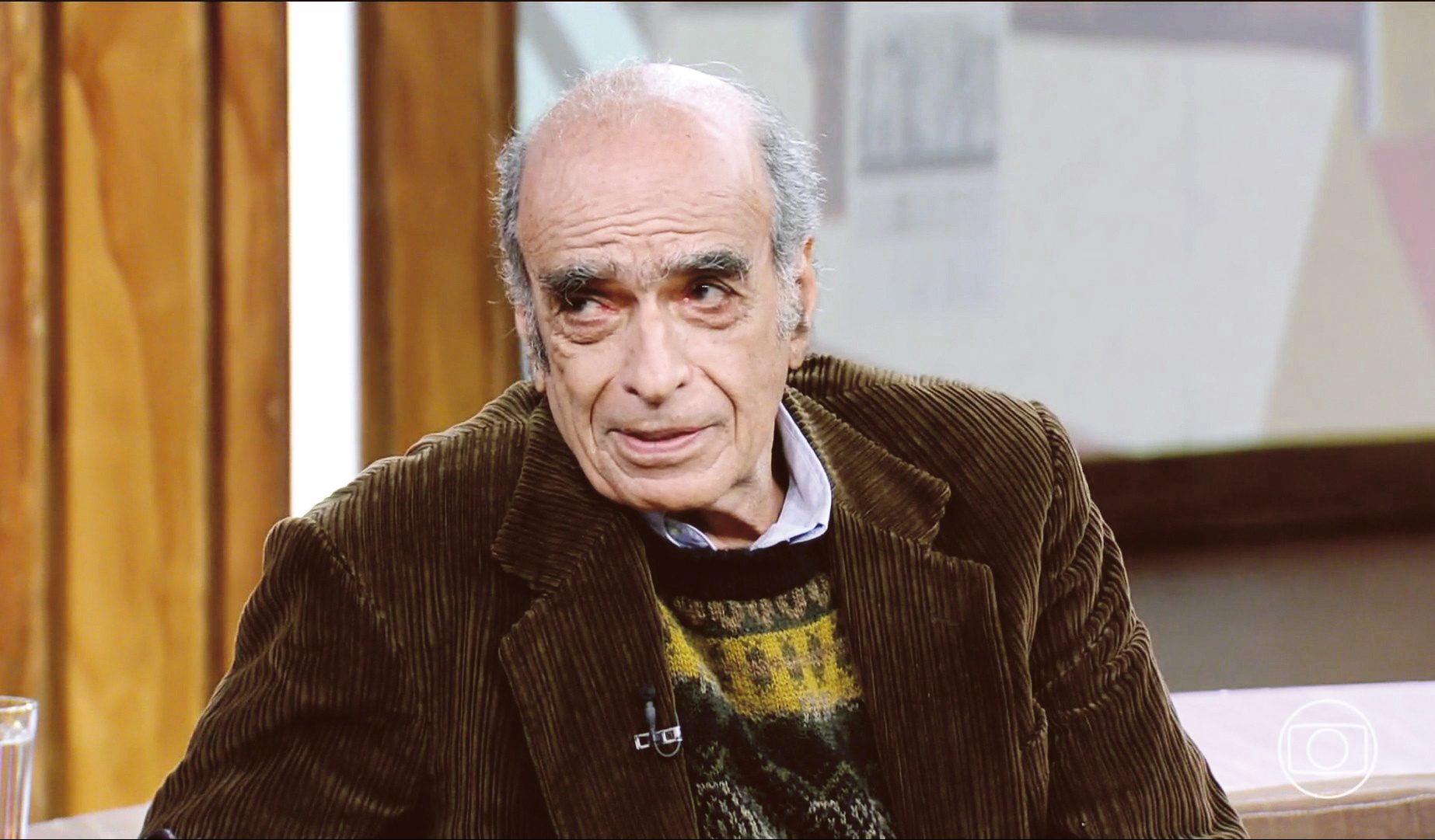

Mário Figueiredo é professor catedrático do Técnico e um dos investigadores mais respeitos e citados em todo o mundo, precisamente pelo se vasto trabalho de várias décadas em aprendizagem automática (machine learning). Merece particular destaque a sua designação como “Fellow” da European Association for Signal Processing (EURASIP). No artigo que publicou no jornal Público traça as linhas gerais do trabalho dos laureados, realçando a importância do poder do pensamento interdisciplinar (Publicado na edição de 8 de outubro de 2024 do jornal Público, disponível em: https://www.publico.pt/2024/10/08/ciencia/opiniao/nobel-fisica-salienta-pensamento-interdisciplinar-2107071

Tivemos a oportunidade de conhecer o Professor Mário Figueiredo numa Conferência sobre Inteligência Artificial realizada na Culturgest, na sua excelente intervenção traçou as linhas gerais da evolução da IA – Disponível em: https://www.youtube.com/watch?v=AHZTzJfpV5s&t=1110s.

Foi um privilégio, termos entrevistado o Professor Mário Figueiredo no âmbito da nossa investigação académica, mas também o seu acolhimento facilitando que um mestrando da área das humanidades tivesse a oportunidade de ser coorientado pelo Técnico.

Pergunta: Começava por perguntar qual é a sua opinião acerca dos enviesamentos dos sistemas de IA que podem resultar da aplicação do modelo de aprendizagem automática?

Resposta: A questão tem sido motivo de debate, especialmente no que respeita ao nível em que devem começar as preocupações com aspetos éticos e de justiça. No domínio da IA, estes aspetos têm sido considerados tanto em níveis mais elevados quanto em níveis mais práticos, ou seja, próximos das aplicações. Os enviesamentos sociais, raciais, de género ou outros, que possam estar embutidos em determinados métodos ou algoritmos que tomam decisões, normalmente têm origem na fase de treino e aprendizagem.

Pergunta: Na sua opinião, deve haver um equilíbrio entre os diversos níveis onde esta questão é considerada?

Resposta: Sim, embora o meu primeiro instinto seja colocar o problema num nível mais prático, ou seja, os algoritmos são muito flexíveis e podem ser usados de várias maneiras. A questão fundamental diz respeito a dois aspetos: como serão usados e por quem. Uma empresa, um banco ou uma instituição pública que usa um algoritmo de IA para tomar decisões deve ter muito cuidado com a sua configuração, treino e parametrização, assim como com a forma como o utiliza. Todos estes aspetos são críticos.

É claro que, num nível superior, há muitos outros aspetos que se podem e devem estudar. Os algoritmos de aprendizagem da IA são passíveis de estudo formal e matemático, por isso entendo que existem várias camadas na abordagem do problema.

Pergunta: Quando se utiliza a aprendizagem automática, é possível programar o algoritmo para evitar os enviesamentos que existem nos dados?

Resposta: Focar estes problemas no contexto da aprendizagem automática revela que vários enviesamentos estavam já presentes nas decisões humanas e que se tornam evidentes quando se analisa a questão com mais atenção. Esses enviesamentos transferiram-se para o algoritmo porque já estavam nas decisões que foram tomadas anteriormente. Assim, os algoritmos foram treinados para replicar, de certa forma, essas decisões humanas. Portanto, o algoritmo apenas reflete os enviesamentos anteriores.

Pergunta: Pode citar alguns exemplos?

Resposta: Há vários exemplos famosos. Um caso notório é o que ocorreu no departamento de recursos humanos da Amazon, onde um algoritmo foi utilizado para selecionar candidatos para determinadas posições. Descobriu-se que havia um enviesamento que evitava a contratação de mulheres, resultante não do algoritmo em si, mas dos dados com que o algoritmo tinha sido treinado, ou seja, as contratações anteriores já apresentavam esse enviesamento. A emergência deste enviesamento no algoritmo, quando sujeito a um escrutínio mais rigoroso, gerou receios quanto às consequências futuras. O enviesamento existia antes do uso do algoritmo e era refletido nos dados.

Pergunta: Quando ocorrem situações semelhantes ao exemplo que deu, na sua opinião, quem deve ser responsabilizado?

Resposta: A culpa é uma palavra carregada. Na minha opinião, essa responsabilidade é sempre partilhada, em graus diferentes. Os técnicos, ou engenheiros, que montam os sistemas têm um papel crucial, mas não cabe ao investigador que desenvolveu o algoritmo resolver esse problema. É importante que os investigadores, ao disponibilizarem os algoritmos para utilização em empresas ou outras entidades, alertem para o potencial de decisões enviesadas se os dados contiverem esses enviesamentos. Quem faz a transição dos algoritmos mais abstratos para a prática deve ter essa consciência. Os dirigentes das entidades que utilizam esses algoritmos também precisam estar cientes disso. Quando um dirigente configura projetos e escolhe as equipas, deve considerar estas questões nas especificações do caderno de encargos.

Pergunta: Na sua opinião, nestas situações, a responsabilidade deve ser partilhada?

Resposta: A atribuição da responsabilidade não é linear. Por exemplo, num acidente de automóvel que resulta na morte de um peão, pode-se questionar quem é responsável: o condutor, o engenheiro que desenhou o carro ou a pessoa que comprou o carro. Obviamente, há uma responsabilidade partilhada, mas com diferentes graus. A pessoa que está mais próxima do problema, que utiliza a aplicação prática, tem, na minha opinião, a maior parte da responsabilidade. Conhecer as potencialidades e limitações do método é fundamental. Não se pode alegar ignorância, é necessário que se recolha a informação necessária.

Pergunta: Qual é a sua opinião sobre a cooperação entre a universidade, a sociedade civil e a Administração Pública? Da sua experiência, quais os estímulos necessários para que as empresas procurem colaboração com instituições de ensino superior?

Resposta: Em Portugal, até não há muitos anos, a relação entre universidades e empresas não era das melhores. Isso devia-se, em parte, ao nível académico ou profissional dos empresários, que era relativamente baixo, gerando desconfiança em relação às universidades. Além disso, as universidades muitas vezes concentram-se na sua atividade académica, o que pode levar a um desinteresse pelos aspetos mais práticos. Também havia pouca incorporação de tecnologias avançadas na indústria portuguesa, devido a questões económicas e de gestão.

Pergunta: Como compararia a nossa situação com outros países, nomeadamente do espaço da União Europeia?

Resposta: Não se pode comparar com países como a Alemanha ou a França. A tecnologia mais avançada que usamos é, em grande parte, importada, embora haja várias exceções. Temos empresas em Portugal que fazem investigação e desenvolvimento de novos produtos, como nas indústrias farmacêuticas e eletrónica.

Pergunta: Na sua opinião esta situação tem tido ou pode vir a ter alguma inversão positiva?

Resposta: Nos últimos 10 / 15 anos, a situação tem vindo a mudar. A incorporação tecnológica na indústria portuguesa aumentou significativamente, especialmente com o surgimento de start-ups. É comum agora ver empresas a contratar doutorados em várias engenharias, em física e biologia para desenvolverem projetos de investigação em contexto empresarial. Esta prática, que era rara, está a tornar-se mais frequente. Embora muitos doutorados ainda trabalhem na academia ou no estrangeiro, acredito que isso está a mudar.

Pergunta: Como descreveria esta situação na Europa e nos Estados Unidos da América (EUA)?

Resposta: Nos EUA e, em menor medida, na Europa, especialmente nos países anglo-saxónicos, existem internships (programas de estágios) que melhoram as relações entre universidades e empresas. Os estudantes de doutoramento em áreas como ciência da computação podem estagiar em empresas, levando os seus conhecimentos e criando um canal de comunicação importante. Essas práticas seriam muito úteis em Portugal e representariam um benefício mútuo, contribuindo para melhorar as ligações entre ambos os setores. Nos EUA, estes estágios são, na minha opinião, um dos fatores que ajudam a estabelecer relações de confiança entre empresas e investigação, algo que tem vindo a melhorar em Portugal.

Pergunta: A primeira versão da Estratégia Portuguesa para a IA previa a criação de uma Comissão Nacional para a Ética da IA. Considerando que, no âmbito do AI Act (Regulamento da IA), publicado em 12 de julho deste ano, Portugal deverá indicar uma entidade que fiscalize e autorize alguns sistemas de IA, pensa que nessa entidade também deverá ser criada uma secção para a Ética da IA?

Resposta: Penso que faz mais sentido termos um organismo abrangente que inclua tanto a regulamentação quanto a ética. Tudo o que envolve dados deveria estar alinhado com o regulamento geral de proteção de dados. Acredito que pode ser expandido para incluir a tomada de decisões em matéria de dados, integrando uma abordagem global que considere todos os aspetos envolvidos. Não é possível separar a IA e a aprendizagem automática dos dados, pois, sem os dados, os sistemas de IA não funcionam e, sozinhos, os dados têm pouco interesse sem as ferramentas computacionais.

Pergunta: Parece-lhe que se pode equacionar a possibilidade de alargar o âmbito de atuação e as competências da Comissão Nacional de Proteção de Dados (CNPD)?

Resposta: Sim, penso que sim, até a nível europeu. Essa é uma hipótese a considerar, embora ainda não tenha refletido muito sobre a questão. Pode haver contra-argumentos, mas não me ocorre nenhum no momento.

Pergunta: Na sua opinião, quais são as principais dificuldades de implementação da IA na Administração Pública?

Resposta: A Administração Pública é caracterizada por uma excessiva burocratização, o que, embora seja relativamente normal, resulta em morosidade nos processos. As áreas da IA avançam rapidamente e exigem equipamentos que se tornam obsoletos em pouco tempo. Também pode ser complicado ter interações e colaborações com entidades privadas. Por exemplo, nos hospitais e centros de saúde, há sempre escassez de recursos, com as pessoas sobrecarregadas de trabalho e grandes complicações burocráticas até para adquirir itens básicos. A falta de recursos afeta a motivação e a abertura para a colaboração em inovações tecnológicas, pois as equipas sentem que precisam resolver questões mais básicas antes de se aventurar em projetos mais ambiciosos.

Pergunta: Quais são as grandes dificuldades da IA nos campos que veem por aí?

Resposta: Numa perspetiva especulativa, há questões sobre a possibilidade de criar uma IA geral. Questões relativas ao desenvolvidos de sistemas artificiais mais inteligentes do que os humanos e se isso representará um perigo para a humanidade são frequentemente debatidas. No entanto, considero essas questões muito especulativas e não me preocupam. Temos problemas mais prementes a resolver. É interessante discutir essas questões do ponto de vista filosófico, mas, em termos de aplicações práticas, ainda estamos um pouco distantes.

(Entrevista realizada no âmbito da investigação académica “Novos Desafios da Administração Pública: Inteligência Artificial e Ética nos Sistemas Inteligentes com Autonomia”, que concluímos em 2022 e atualizada com o entrevistado em 12.11.2024).